抓码王自动更新机制解析

在当今数据驱动的时代,信息的准确性和时效性变得愈发重要,对于“抓码王”这类高度依赖数据抓取和分析的工具而言,自动更新功能是其核心竞争力之一,本文将深入探讨抓码王的自动更新机制,包括其工作原理、技术实现、面临的挑战以及专家解答与落实建议,为广大用户提供一个全面而深入的理解。

一、抓码王自动更新机制概述1.1 定义与重要性

抓码王的自动更新机制指的是系统能够定期或不定期地从指定数据源获取最新数据,并自动进行处理和分析,确保用户能够实时掌握最新信息,这一机制的重要性体现在以下几个方面:

- 确保数据的时效性和准确性,提升决策效率;

- 减少人工干预,降低人力成本;

- 提高系统的智能化水平,增强用户体验。

1.2 工作原理

抓码王的自动更新机制通常包括以下几个关键步骤:

- 数据源监控:系统持续监控指定数据源的变化情况,以便及时发现新数据;

- 数据抓取:当检测到新数据时,系统自动启动抓取程序,将新数据获取到本地;

- 数据处理:对抓取到的数据进行清洗、转换和存储,以便后续分析使用;

- 数据分析:基于预设的分析模型或算法,对新数据进行处理和分析;

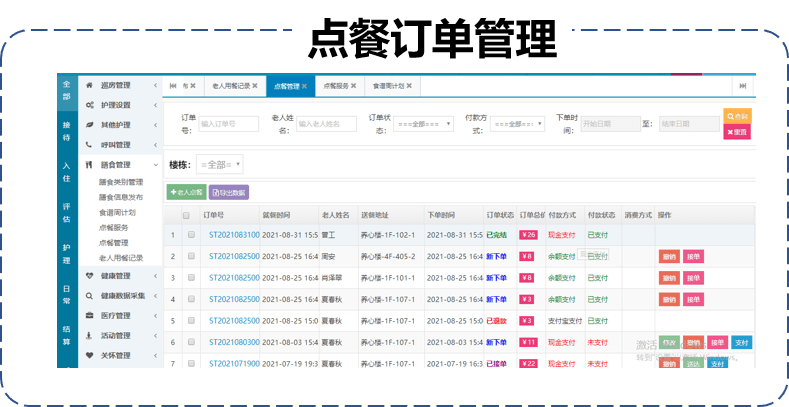

- 结果展示:将分析结果以可视化报表或通知的形式呈现给用户。

二、技术实现细节2.1 数据源监控技术

数据源监控是自动更新机制的基础,抓码王通常采用以下几种技术手段来实现数据源的有效监控:

- API接口调用:通过定期调用数据源提供的API接口,获取数据变更情况;

- Web爬虫技术:利用爬虫技术定期访问目标网页,抓取页面内容变化;

- 数据库触发器:在数据库层面设置触发器,当数据发生变更时,自动触发更新流程;

- 消息队列:使用消息队列(如Kafka、RabbitMQ等)来接收数据源推送的数据变更消息。

2.2 数据抓取与处理技术

数据抓取是自动更新机制的核心环节,抓码王在这一环节主要采用以下技术和工具:

- 网络爬虫框架:如Scrapy、BeautifulSoup等,用于编写高效的爬虫程序;

- HTTP客户端库:如Requests、Aiohttp等,用于发送网络请求和接收响应;

- 数据处理库:如Pandas、NumPy等,用于对抓取到的数据进行清洗和转换;

- 数据库技术:如MySQL、MongoDB等,用于存储和管理抓取到的数据。

2.3 数据分析与展示技术

数据分析与展示是自动更新机制的最后一环,抓码王在这一环节主要采用以下技术和工具:

- 数据分析库:如SciPy、Statsmodels等,用于进行统计分析和建模;

- 机器学习框架:如TensorFlow、Scikit-learn等,用于构建预测模型和分类器;

- 数据可视化库:如Matplotlib、Seaborn等,用于生成直观的图表和报表;

- 前端展示技术:如HTML/CSS/JavaScript等,用于构建用户友好的Web界面。

三、面临的挑战与解决方案3.1 数据源多样性与稳定性问题

抓码王需要面对各种不同类型的数据源,包括结构化数据(如数据库)、半结构化数据(如XML、JSON)和非结构化数据(如文本、图片),不同数据源的稳定性和可靠性也各不相同,这给数据抓取和处理带来了一定的挑战。

解决方案:

- 采用多种数据抓取技术,根据数据源类型选择合适的抓取方法;

- 设置重试机制和异常处理机制,确保在数据源出现问题时能够及时恢复;

- 对不稳定的数据源进行降级处理或备份处理,确保系统的连续性和稳定性。

3.2 数据抓取效率与性能优化

随着数据量的不断增加和数据源的不断扩展,数据抓取的效率和性能成为制约自动更新机制的关键因素,如何提高数据抓取的效率和性能成为亟待解决的问题。

解决方案:

- 采用分布式爬虫架构,通过多台机器同时抓取数据来提高抓取速度;

- 使用异步IO和多线程技术来优化网络请求的处理速度;

- 对抓取到的数据进行压缩和去重处理,减少数据传输和存储的开销;

- 定期对爬虫程序进行性能评估和优化调整。

3.3 数据分析与可视化的挑战

数据分析与可视化是自动更新机制的高级阶段也是最具挑战性的阶段之一,如何从海量数据中提取有价值的信息并将其以直观的方式呈现给用户是一个重要的问题。

解决方案:

- 引入高级数据分析方法和机器学习算法来挖掘数据中的隐藏模式和关联关系;

- 使用专业的数据可视化工具和技术来生成高质量的图表和报表;

- 根据用户需求和使用场景定制个性化的数据分析报告;

- 提供交互式的数据分析平台让用户能够自主探索和分析数据。

四、专家解答与落实建议4.1 专家解答常见问题

问:抓码王的自动更新机制是如何确保数据抓取的准确性的?

答:抓码王采用多种技术手段来确保数据抓取的准确性包括使用精确的XPath或CSS选择器来定位网页元素、设置合理的抓取频率和深度以避免过度抓取和被封禁、以及对抓取到的数据进行严格的清洗和验证等,此外还会根据用户的反馈和需求不断优化和完善抓取规则和算法以提高数据抓取的准确性和稳定性。

问:如何评估抓码王自动更新机制的性能?

答:可以通过以下几个指标来评估抓码王自动更新机制的性能:抓取速度(单位时间内抓取的数据量)、抓取成功率(成功抓取的数据条数占总抓取任务的比例)、数据完整性(抓取到的数据是否完整无缺)、系统资源占用(如CPU、内存使用率)等,通过定期收集和分析这些指标可以了解自动更新机制的性能状况并进行针对性的优化和改进。

4.2 落实建议与最佳实践分享

- 建立完善的数据监控体系:通过设置合理的监控指标和预警机制实时掌握数据的更新情况和系统的运行状态;

- 定期维护和更新抓取规则:根据数据源的变化和用户需求的调整定期更新抓取规则和算法以确保数据的时效性和准确性;

- 加强数据分析能力建设:引入先进的数据分析方法和工具提升数据分析的效率和深度为用户带来更有价值的洞察和决策支持;

- 注重用户体验和反馈循环:通过收集用户反馈和需求不断优化和完善产品功能和界面设计提升用户体验和满意度;

- 建立专业的技术支持团队:为用户提供及时的技术咨询和问题解决服务确保系统的稳定运行和高效使用。

转载请注明来自上海绿立方农业发展有限公司,本文标题:《抓码王 自动更新,专家解答解释落实_bb071.89.62》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号